علیبابا، همون شرکتی که بیشتر با سایتهای خرید اینترنتی میشناسیمش، تو دنیای هوش مصنوعی هم حسابی پیشرفت کرده. حالا جدیدترین مدلش، یعنی Qwen 2.5 Max رو معرفی کرده که کلی سر و صدا کرده. این مدل قراره با بهترینهای بازار مثل GPT-4o، Claude 3.5 Sonnet و DeepSeek V3 رقابت کنه.

اما یه چیزی! کووِن 2.5 مکس یه مدل استدلالی (Reasoning Model) نیست. یعنی چی؟ یعنی مثل بعضی مدلهای دیگه (مثلاً DeepSeek R1) نمیتونه بهت نشون بده که چطور به یه جواب رسیده. فقط نتیجه رو میگه، بدون اینکه پشت صحنهی فکرهاش رو نمایش بده. اما خب، این اصلاً به این معنی نیست که مدل ضعیفه!

Qwen 2.5 Max دقیقاً چیه؟

Qwen 2.5 Max قویترین مدل هوش مصنوعیایه که علیبابا تا حالا ساخته. یه مدل همهکاره که قراره با بزرگترین هوشهای مصنوعی دنیا رقابت کنه.

چند نکته مهم درباره Qwen 2.5 Max:

1- ساختهی علیبابا؛ همون شرکت معروف چینی که فقط توی تجارت الکترونیک نیست، بلکه توی هوش مصنوعی و محاسبات ابری هم حسابی سرمایهگذاری کرده.

2- متنباز نیست؛ یعنی برعکس بعضی مدلهای دیگه، نمیتونی به وزنهاش (Weights) دسترسی داشته باشی.

3- ۲۰ تریلیون توکن؛ یعنی روی حجم عظیمی از دادهها آموزش دیده و کلی اطلاعات داره.

4- رقیب جدی GPT-4o و DeepSeek V3؛ اما مثل DeepSeek R1 روند فکر کردنش رو نشون نمیده.

به نظر میاد علیبابا داره آرومآروم مسیر خودش رو توی هوش مصنوعی پیدا میکنه و شاید توی نسخههای بعدی (مثلاً Qwen 3) یه مدل استدلالی اختصاصی هم معرفی کنه.

کووِن 2.5 Max یه مدل هوش مصنوعی قوی و پیشرفتهست که میتونه کلی کار راه بندازه. هنوز معلوم نیست که از پس GPT-4o یا DeepSeek V3 برمیاد یا نه، ولی مطمئناً یه رقیب جدیه.

برای آشنایی با دیپ سیک و مدل V3 میتونی مقاله معرفی Deepseek AI و برای آشنایی با مدل R1 این هوش مصنوعی، میتونی مقاله معرفی DeepSeek R1 در بلاگ دیکاردو رو مطالعه کنی!

Qwen 2.5 Max چطوری کار میکنه؟

کووِن 2.5 مکس از یک روش هوشمندانه به نام “Mixture-of-Experts” (MoE) استفاده میکنه. این همون تکنیکی هست که در مدل DeepSeek V3 هم دیده میشه و به مدل کمک میکنه که در عین قوی بودن، هزینههای پردازشی رو هم کنترل کنه. اما این یعنی چی؟ بیاید سادهتر توضیح بدیم.

Mixture-of-Experts (MoE) چیه و چرا مهمه؟

فرض کنید یه تیم از متخصصهای مختلف دارید: یه نفر توی فیزیک حرفهایه، یکی توی زبانشناسی و یکی دیگه توی تاریخ. حالا وقتی یه سؤال ازشون میپرسید، لازم نیست همهی تیم جواب بدن؛ فقط اون کسی که توی اون زمینه تخصص داره، وارد عمل میشه.

Qwen 2.5 Max هم دقیقاً همین کار رو میکنه!

برخلاف مدلهای سنتی که برای هر ورودی تمام پارامترهاشون رو فعال میکنن، مدلهای MoE فقط بخشهایی از خودشون رو که لازمه فعال میکنن. یعنی اگر یه سؤال در مورد تاریخ بپرسید، همون بخشهای مرتبط با تاریخ فعال میشن و بقیهی مدل غیرفعال میمونه.

چرا این روش خوبه؟

1- سرعت بالاتر: چون فقط بخشهای مهم مدل فعال میشن و بقیه بیخودی پردازش نمیشن.

2- مصرف منابع کمتر: باعث میشه که مدل به قدرت پردازشی خیلی بالایی نیاز نداشته باشه.

3- امکان رقابت با مدلهای سنگین مثل GPT-4o و Claude 3.5 Sonnet، بدون اینکه هزینهی محاسباتی سرسامآوری داشته باشه.

در مقابل، مدلهای متراکم (Dense Models) مثل GPT-4o همیشه همهی پارامترهاشون رو برای هر ورودی فعال میکنن، که باعث میشه قدرت پردازش بیشتری نیاز داشته باشن. کووِن 2.5 مکس با استفاده از MoE میتونه هم قوی بمونه و هم منابع کمتری مصرف کنه!

Qwen 2.5 Max چطور آموزش دیده؟

Qwen 2.5 Max روی 20 تریلیون توکن آموزش دیده! ولی 20 تریلیون یعنی چقدر؟ یه جورایی یه عدد عجیب و بزرگه، پس بذارید با یه مثال درکش کنیم.

فرض کنید کل این دادهها به کلمات تبدیل بشن، اون وقت میشه حدود 15 تریلیون کلمه! برای مقایسه، کتاب معروف 1984 جورج اورول تقریباً 89 هزار کلمه داره. یعنی چی؟ یعنی Qwen 2.5 Max انگار 168 میلیون بار این کتاب رو خونده!

اما فقط داشتن کلی داده، یه مدل هوش مصنوعی رو باهوش و کاربردی نمیکنه. پس علیبابا چند مرحلهی دیگه رو هم برای بهتر کردنش انجام داده:

چطور مدل رو دقیقتر کردن؟

1- تنظیم دقیق با کمک انسانها (SFT – Supervised Fine-Tuning):

یه سری کارشناس حرفهای نشستند و جوابهای خیلی باکیفیت نوشتن تا مدل یاد بگیره چطور جوابهای بهتر و مفیدتری بده. یه جورایی مثل یه معلم که جوابهای درست رو به دانشآموزش نشون میده!

2- یادگیری تقویتی از بازخورد انسانی (RLHF – Reinforcement Learning from Human Feedback):

مدل رو طوری آموزش دادن که بهتر درک کنه مردم چه جور جوابهایی رو دوست دارن. یعنی علاوه بر دقت، یاد گرفته که لحن طبیعیتر و مفیدتری داشته باشه.

نتیجه چیه؟

این ترکیب باعث شده Qwen 2.5 Max فقط یه مدل با دادههای زیاد نباشه، بلکه یه مدل دقیق، هوشمند و همگام با درک انسانی باشه!

Qwen 2.5 Max چقدر قویه؟ بررسی معیارها و مقایسه با رقبا

خب، تا اینجا دربارهی Qwen 2.5 Max حرف زدیم، ولی حالا وقتشه که ببینیم عملکردش توی تستهای مختلف چطوره و در مقایسه با مدلهای دیگه چه جایگاهی داره؟

برای ارزیابی دقیقتر، این مدل رو توی یه سری معیارهای استاندارد آزمایش کردن تا مشخص بشه چقدر توی کارهای مختلف قوی و دقیق عمل میکنه. این معیارها دو نوع مدل رو بررسی میکنن:

1- مدلهای آموزشی (Instruct): مدلهایی که برای کاربردهای واقعی مثل چت، کدنویسی و پرسش و پاسخ تنظیم شدن.

2- مدلهای پایه (Base Models): مدلهای خام که قبل از تنظیم دقیق، فقط روی دادههای عمومی آموزش دیدن.

حالا بیایید ببینیم کووِن 2.5 Max توی این تستها چه عملکردی داشته و در مقایسه با GPT-4o، Claude 3.5 Sonnet و DeepSeek V3 چه جایگاهی داره.

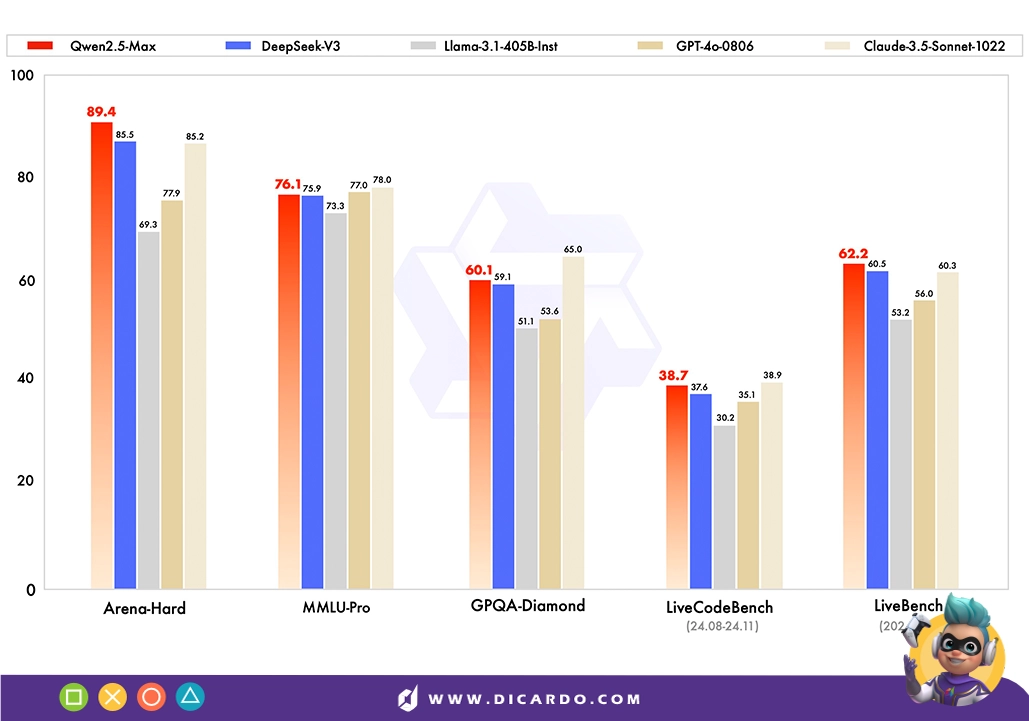

عملکرد Qwen 2.5 Max در معیارهای مختلف

1- Arena-Hard (ترجیح کاربران در مکالمات)

Qwen 2.5 Max امتیاز 89.4 رو گرفته! این یعنی مردم ترجیح میدن جوابهای این مدل رو بخونن تا DeepSeek V3 (85.5) و Claude 3.5 Sonnet (85.2). پس توی مکالمات، Qwen عملکرد خیلی خوبی داره.

2- MMLU-Pro (دانش و استدلال)

امتیاز 76.1 برای Qwen 2.5 Max → یه ذره از DeepSeek V3 (75.9) جلوتره، ولی هنوز Claude 3.5 Sonnet (78.0) و GPT-4o (77.0) بهتر عمل میکنن.

3- GPQA-Diamond (دانش عمومی و پرسش و پاسخ)

کووِن 2.5 Max با امتیاز 60.1 از DeepSeek V3 (59.1) بهتره، ولی از Claude 3.5 Sonnet (65.0) عقبتره. یعنی هنوز توی دانش عمومی جای پیشرفت داره.

4- LiveCodeBench (توانایی کدنویسی)

اینجا Qwen 2.5 Max با 38.7 تقریباً برابر با DeepSeek V3 (37.6) عمل کرده، ولی Claude 3.5 Sonnet با 38.9 یه کوچولو جلوتره. یعنی توی برنامهنویسی هم رقابتیه، اما بینقص نیست.

5- LiveBench (عملکرد کلی هوش مصنوعی در دنیای واقعی)

اینجا کووِن 2.5 Max با امتیاز 62.2 پیشتازه! و از DeepSeek V3 (60.5) و Claude 3.5 Sonnet (60.3) جلوتره. این یعنی یه مدل همهفنحریفه که توی کاربردهای متنوع عملکرد خوبی داره.

نتیجه:

1- Qwen 2.5 Max یه مدل قوی و همهکارهست که توی ترجیح کاربران و وظایف هوش مصنوعی عمومی از بیشتر رقباش بهتر عمل میکنه.

2- در بخش دانش عمومی و استدلال هنوز جای کار داره، ولی همچنان رقابتیه.

3- در کدنویسی تقریباً همسطح DeepSeek V3 و Claude 3.5 Sonnet هست، ولی هنوز بهترین نیست.

4- در مجموع، یه مدل پیشرفتهست که توی خیلی از بخشها میتونه جایگزین مدلهای معروف مثل GPT-4o و Claude 3.5 Sonnet بشه.

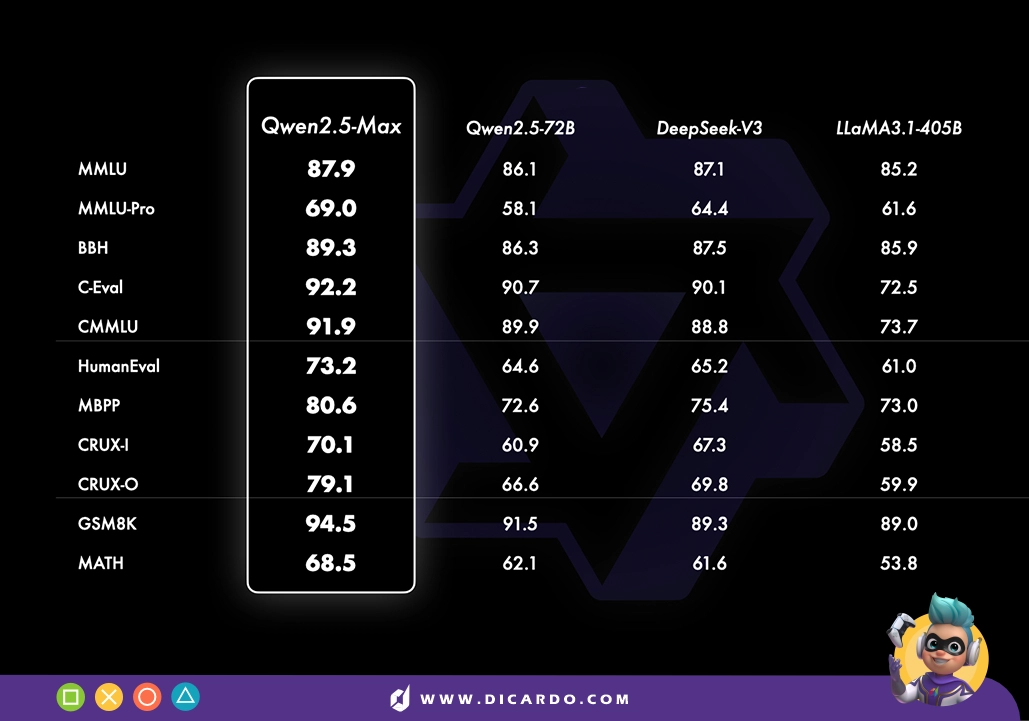

مقایسه مدلهای پایه: Qwen 2.5 Max در برابر رقبا

خب، بریم سراغ مقایسهی مدلهای پایه!

اینجا خبری از مدلهای اختصاصی مثل GPT-4o و Claude 3.5 Sonnet نیست، چون نسخههای پایهی این مدلها بهطور عمومی در دسترس نیستن. پس رقابت بین مدلهای open-weight مثل Qwen 2.5 Max، DeepSeek V3، LLaMA 3.1-405B و Qwen 2.5-72B برگزار شده.

اگه بخوایم ساده بگیم، این مقایسه به ما یه تصویر شفاف از جایگاه Qwen 2.5 مکس بین مدلهای پیشرو Open-Source میده.

Qwen 2.5 Max در معیارهای مختلف چه جایگاهی داره؟

1- دانش عمومی و درک زبان (MMLU، MMLU-Pro، BBH، C-Eval، CMMU)

Qwen 2.5 Max توی همهی این تستها پیشتازه!

- MMLU: امتیاز 87.9

- C-Eval: امتیاز 92.2

یعنی چی؟ یعنی این مدل توی درک زبان و دانش عمومی از DeepSeek V3 و LLaMA 3.1-405B جلوتره و میتونه اطلاعات رو بهتر پردازش کنه.

2- کدنویسی و حل مسئله (HumanEval، MBPP، CRUX-I، CRUX-O)

بازم Qwen 2.5 مکس صدرنشین شده!

- HumanEval: امتیاز 73.2

- MBPP: امتیاز 80.6

این یعنی این مدل توی برنامهنویسی عملکرد قویتری نسبت به رقبا داره. اگه دنبال مدلی هستی که توی کدنویسی و حل مسئله دقیقتر عمل کنه، Qwen 2.5 Max انتخاب بهتریه.

3- حل مسئلهی ریاضی (GSM8K، MATH)

استدلال ریاضی یکی از قویترین بخشهای کووِن 2.5 مکس هست!

- GSM8K: امتیاز 94.5 (خیلی جلوتر از DeepSeek V3 با 89.3 و LLaMA 3.1-405B با 89.0)

- MATH: امتیاز 68.5 (یکم بهتر از رقبا، ولی هنوز جای پیشرفت داره)

یعنی چی؟ یعنی این مدل توی ریاضیات مقدماتی (GSM8K) خیلی قویه، ولی توی مسائل پیچیدهتر (MATH) هنوز جای پیشرفت داره.

نتیجه:

1- Qwen 2.5 Max توی بیشتر معیارها پیشتازه، بهخصوص در درک زبان، دانش عمومی، حل مسئله و کدنویسی.

2- توی ریاضیات مقدماتی عالیه، ولی برای حل مسائل پیچیدهتر هنوز جای بهبود داره.

3- در کل، این مدل نسبت به DeepSeek V3 و LLaMA 3.1-405B عملکرد بهتری داره و یه گزینهی قدرتمند توی دنیای مدلهای Open-Weight محسوب میشه.

چطور به Qwen 2.5 Max دسترسی داشته باشیم؟

اگه کنجکاوی که Qwen 2.5 Max رو امتحان کنی، خبر خوب اینه که خیلی راحت میتونی بهش دسترسی داشته باشی! هیچ دردسر خاصی نداره و بدون تنظیمات پیچیده میتونی ازش استفاده کنی.

۱- استفاده از چت Qwen (سادهترین راه!)

سریعترین و راحتترین راه اینه که از پلتفرم چت Qwen استفاده کنی.

یه رابط کاربری تحت وب داره که میتونی درست مثل ChatGPT توی مرورگر خودت باهاش تعامل داشته باشی.

📌 چطور ازش استفاده کنیم؟

1- وارد چت Qwen شو.

2- روی منوی کشویی مدل کلیک کن.

3- Qwen 2.5 Max رو انتخاب کن و شروع کن به چت کردن!

به همین راحتی!

۲- دسترسی از طریق API (برای توسعهدهندهها)

اگه برنامهنویس یا توسعهدهنده هستی و میخوای این مدل رو توی پروژههات استفاده کنی، میتونی از API استودیوی مدل Alibaba Cloud استفاده کنی.

📌 چطور API رو بگیری؟

1- اول باید توی Alibaba Cloud ثبتنام کنی.

2- سرویس Model Studio رو فعال کنی.

3- یه کلید API ایجاد کنی و با فرمت OpenAI ازش استفاده کنی.

اگه قبلاً با APIهای OpenAI کار کردی، ادغامش خیلی سادهست و دردسر خاصی نداره.

حرف آخر

Qwen 2.5 Max قویترین مدل هوش مصنوعی علیبابا تا الان محسوب میشه و قراره با بزرگان این حوزه مثل GPT-4o، Claude 3.5 Sonnet و DeepSeek V3 رقابت کنه. برخلاف بعضی مدلهای قبلی سری Qwen، این مدل Open-Source نیست، ولی همچنان میتونی راحت ازش استفاده کنی. با سرمایهگذاری بزرگ علیبابا توی هوش مصنوعی، احتمالاً نسخهی جدیدتری مثل Qwen 3 هم در راهه!

پس، اگه میخوای این مدل رو امتحان کنی، الان بهترین وقته!

امیدواریم از خوندن این مقاله در بلاگ دیکاردو لذت برده باشی.